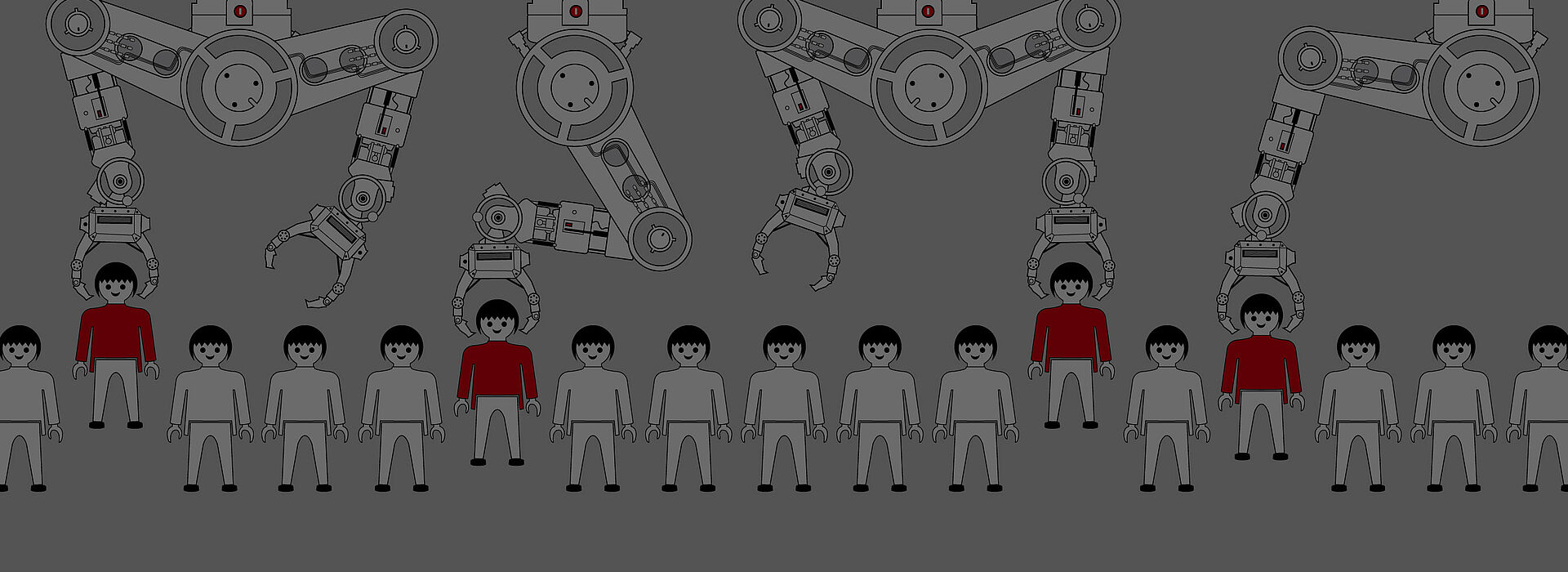

Digitale Chancen oder automatisierte Ungerechtigkeit?

Maschinen treffen immer weitreichendere Entscheidungen über unser Leben – nur selten im Sinne von Gerechtigkeit und Gemeinwohl, allzu oft zur Effizienzsteigerung und Profitmaximierung. Wir wären gut beraten, Digitalisierung nicht Konzernen und neoliberalen Technokrat_innen zu überlassen.

Mit den Arbeitsbedingungen in den Warenlagern von Amazonsteht es nicht zum Besten. Das ist seit Jahren bekannt. Beschäftigte werden auf Schritt und Tritt überwacht. Ihre Arbeitsleistung wird im Minutentakt erfasst – etwa durch die Handgeräte, mit denen Pakete gescannt werden. Wofür werden die Auswertungen genutzt? Kürzlich veröffentlichte Dokumente legen nahe, dass in einem Amazon-Warenlager in den USA innerhalb eines Jahres an die zehn Prozent der Belegschaft wegen „Ineffizienz“ gekündigt wurden – und zwar zum Teil vollautomatisch.

Aussortiert von der Maschine

Der sogenannte Algorithmus – also die Art, wie aus Daten Entscheidungen über Menschen werden – ist in diesem Fall technisch eher trivial. Zuerst wird Verhalten vermessen, dann werden Kennzahlen über die vergangene Produktivität der Arbeitnehmer_innen berechnet. Etwas weniger trivial sind Systeme, die vorgeben, schon vor Antritt einer Beschäftigung vorherzusagen, wie gut jemand die Anforderungen für ein bestimmtes Jobprofil erfüllen wird. Dabei werden etwa Lebensläufe von Bewerber_innen statistisch mit denen des bestehenden Personals verglichen.

Es war wieder Amazon, das ein derartiges System eingesetzt hat – in diesem Fall für höher qualifizierte Jobs. Die Personalabteilung bekam für alle Bewerber_innen eine maschinelle Bewertung von einem bis fünf Sternen zu sehen – ähnlich wie bei Produkten im Online-Shop. Nach einigen Jahren wurde das System aufgegeben, denn es hatte systematisch Frauen diskriminiert. Amazon hat dieses Problem als unlösbar eingeschätzt.

Gelernte Diskriminierung

Frauen wurden bei gleicher Qualifikation durchgängig schlechter bewertet. Warum? Das System wurde mit Lebensläufen und anderen Daten über Amazon-Angestellte der letzten zehn Jahre gefüttert. Nun hatte der Konzern aber in höher qualifizierten Tätigkeitsbereichen schon früher viel mehr Männer als Frauen beschäftigt. Der Berechnungsalgorithmus hat aus dieser Vergangenheit „gelernt“.

Subtile statistische Muster in den Lebensläufen und Formulierungen haben dazu geführt, dass Frauen bei Neubewerbungen selbst dann zuverlässig aussortiert wurden, wenn das Geschlecht bei der Berechnung extra ausgeklammert wurde. Amazon hat diese Praktiken aufgegeben, weil man offensichtlich ein Interesse daran hatte, höher qualifizierte Bewerberinnen nicht zu verlieren.

Billig und effizient

Die automatisierte Bewertung und Reihung von Bewerbungen wird aber in vielen Bereichen weiterhin eingesetzt – und zwar rapide zunehmend und oft mit äußerst esoterischer Datenbasis. Die US-Firma HireIQ analysiert etwa Stimmproben von automatisierten Online-Bewerbungsgesprächen und verspricht Call Centern, schlechte Kandidat_innen auszusortieren. Damit soll der Einstellungsprozess billiger und effizienter werden.

Das Unternehmen wirbt sogar extra damit, dass dessen Technologie keine bestimmten Gruppen diskriminieren würde. Das darf bezweifelt werden, so wie die Zuverlässigkeit der Stimmanalyse ganz generell. HireIQ ist eine von tausend obskuren Firmen überall in der Welt, die den Hype um „künstliche Intelligenz“ als Verkaufsstrategie für sich nutzen.

Künstliche Intelligenz?

Worum geht es bei dieser sogenannten künstlichen Intelligenz? Kaum um die – wahlweise spektakulären oder apokalyptischen – Bilder, die wir aus Literatur und Film im Kopf haben, sondern meist um ziemlich trockene statistische Methoden. Es gibt einige Anwendungen, die schon recht gut funktionieren. Vieles davon hat mit der Verarbeitung von Sprache, Ton oder Bild zu tun. Spracherkennung klappt etwa nicht schlecht.

Eine andere Art der Anwendung sind Empfehlungssysteme, Stichwort „Kunden, die X gekauft haben, kauften auch Y“. Das Empfehlungssystem mit dem derzeit größten gesellschaftlichen Einfluss ist wohl Googles YouTube. Dessen Empfehlungen und die automatisch abgespielten Folgevideos bestimmen 70 % dessen, was Milliarden Menschen sehen.

Ziele mit Nebenwirkungen

Nach welchen Kriterien YouTube berechnet, welche Videos empfohlen werden, wissen wir nicht im Detail. Untersuchungen und Angaben des Konzerns deuten jedoch darauf hin, dass es nur ein einziges zentrales Kriterium gibt: YouTube empfiehlt zu jedem Zeitpunkt genau das Video, von dem der Algorithmus annimmt, dass es uns am längsten auf der Plattform hält.

Das hat Nebenwirkungen. Um Klicks zu maximieren, empfiehlt YouTube je nach Persönlichkeit nicht nur Videos über zuckersüße Tiere oder Flugzeugabstürze, sondern gern auch gemeingefährliche politische Angstmache und Hetze. Egal ob Google, Amazon oder Facebook – deren Empfehlungssysteme sind von wirtschaftlichen Zielen geprägt. Das Wohlergehen von Nutzer_innen und Gesellschaft spielt bestenfalls eine Nebenrolle.

Die vorab definierten Ziele bestimmen, wie solche Technologien wirken. Das ist auch bei weitaus weniger weltumspannenden algorithmischen Entscheidungssystemen der Fall. Das AMS Österreich hat ein Modell entwickelt, das Arbeitslose beinahe vollautomatisiert in gute, mittelgute oder hoffnungslose Fälle einteilt. Warum? Arbeitslose der Kategorie C sollen künftig „mit weniger Ressourcenaufwand“ betreut werden, wie schon im Rechnungshofbericht 2017 nachzulesen ist.

Eine andere Digitalisierung?

Diese Beispiele zeigen, wie die real existierende Digitalisierung dazu dienen kann, über die Köpfe der Menschen hinweg Ziele wie Kosteneinsparungen und Effizienzsteigerung durchzusetzen – im kommerziellen wie im öffentlichen Bereich. Anstatt gesellschaftliche Ungleichheit und Diskriminierung politisch anzugehen, verschwinden sie hinter Maschinen – und scheinbar objektiver wie unangreifbarer Mathematik.

Wobei, nichts gegen Maschinen. Maschinen sind großartig. Aber wo sie Entscheidungen über Menschen treffen, müssen wir über die zugrundeliegenden Ziele reden. Digitale Chancen für alle? Mit technischen Systemen, die einseitig von kurzsichtigen Zielen wie Wachstum, Profit oder Effizienz geprägt sind, wird das nichts. Wenn, dann brauchen wir gemeinwohlorientierte Algorithmen, die Autonomie, Gerechtigkeit und Mitbestimmung ermöglichen.

Wolfie Christl denkt, forscht und schreibt über die gesellschaftlichen Dimensionen von Informationstechnologie. Beim WUK Bildungs- und Beratungstag am 2.10. wird er ausführlicher zum Thema vortragen.

WUK Bildungs- und Beratungstag 2019

Maschine : Mensch

Wer entscheidet in Zukunft über unsere Jobs?

Mi 2.10., 13-17 Uhr, Saal